搜索引擎优化游戏有如此多的移动部分,以至于我们一旦优化了网站的一部分,我们就必须回到我们刚刚开发的部分。

一旦你走出了“我是新来的”阶段,觉得你有一些真正的SEO经验,你可能会开始觉得有些事情你可以花更少的时间去纠正。

可索引性和爬网预算可能是其中的两件事,但忘记它们将是一个错误。

我总是喜欢说,一个有可索引性问题的网站是一个有自己的方式的网站;该网站无意中告诉谷歌不要对其页面进行排名,因为页面加载不正确或重定向次数过多。

如果你认为你不能或不应该把时间花在修复网站的可索引性这一绝对不那么迷人的任务上,那就再想一想。

可索引性问题可能会导致你的排名直线下降,网站流量迅速枯竭。

所以,你的爬行预算必须是最重要的。

在这篇文章中,我将为您提供11个建议,供您在着手提高网站的可索引性时考虑。

跳转到:

ustom爬行率

1.使用谷歌搜索控制台跟踪爬网状态

爬网状态中的错误可能表明您的站点存在更深层的问题。

每30-60天检查一次爬网状态对于识别影响网站整体营销绩效的潜在错误非常重要。

这是搜索引擎优化的第一步;没有它,所有其他努力都是徒劳的。

在侧栏上,您可以在索引选项卡下检查爬网状态。

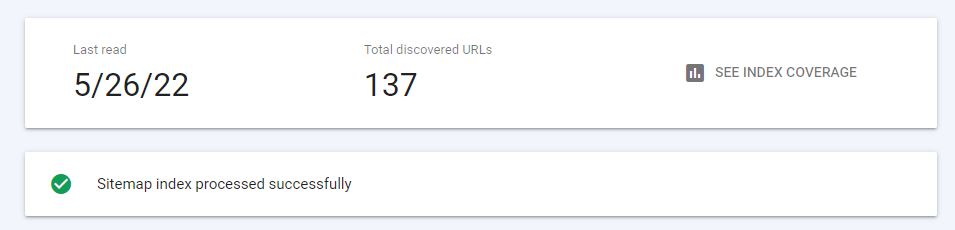

作者截图,2022年5月

作者截图,2022年5月

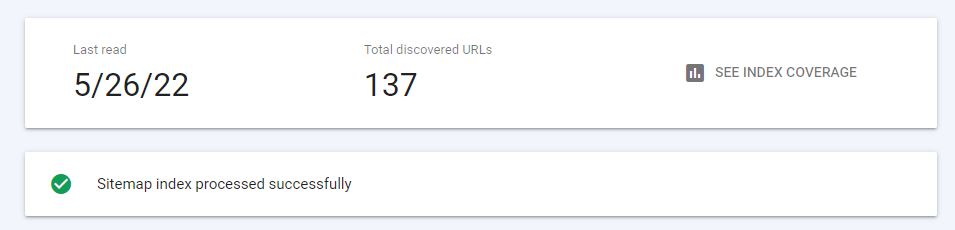

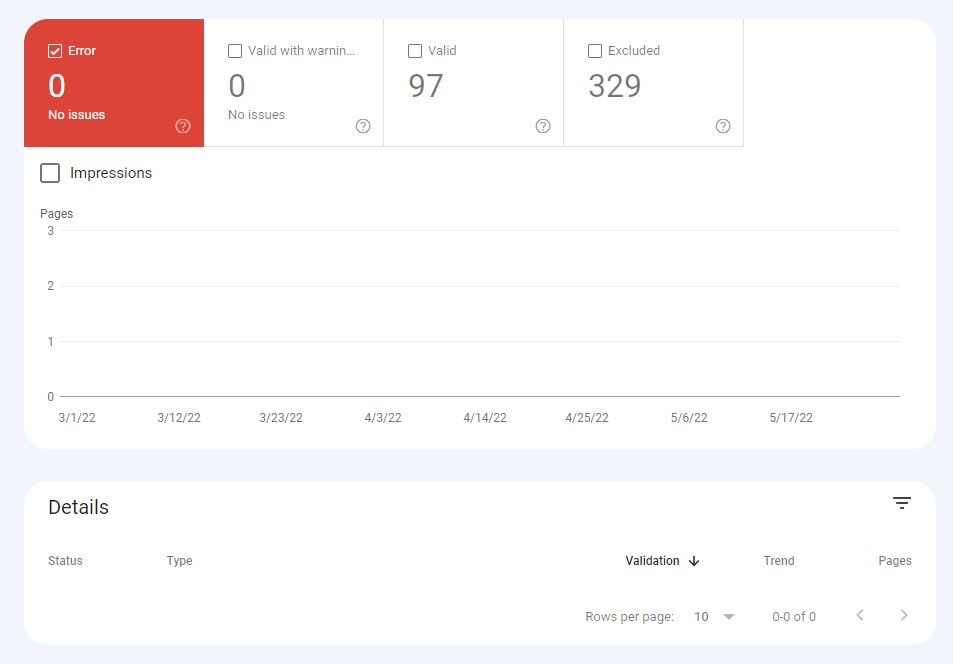

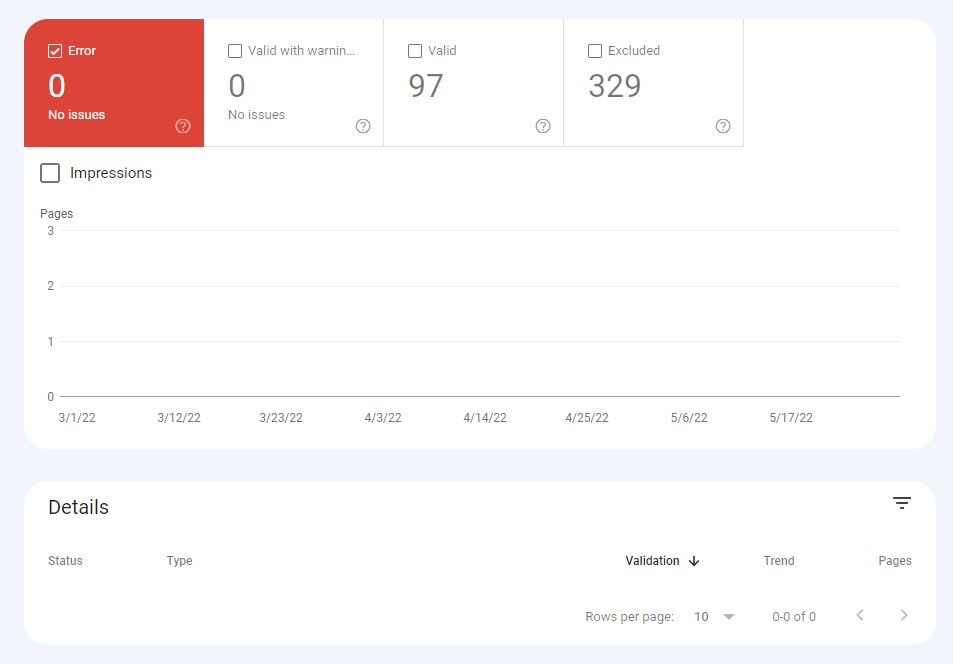

作者截图,2022年5月

作者截图,2022年5月

现在,如果您想删除对某个网页的访问,您可以直接告诉搜索控制台。如果页面被临时重定向或出现404错误,这将非常有用。

410参数将从索引中永久删除页面,因此要小心使用核选项。

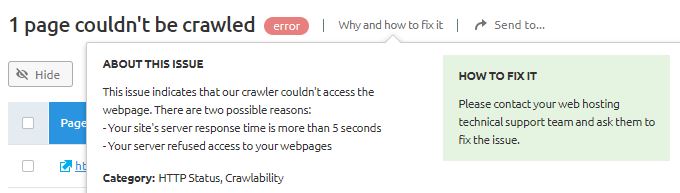

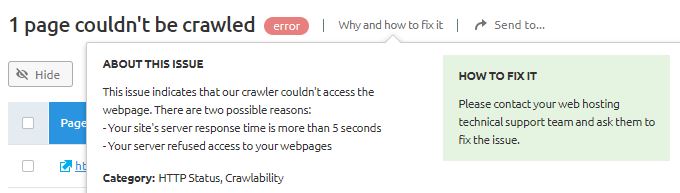

常见爬网错误和解决方案

如果您的网站不幸遇到爬网错误,则可能需要简单的解决方案,或者表明您的网站存在更大的技术问题。

我看到的最常见的爬网错误是:

- DNS错误。

- 服务器错误。

- 机器人。txt错误。

- 404个错误。

作者截图,2022年5月

作者截图,2022年5月

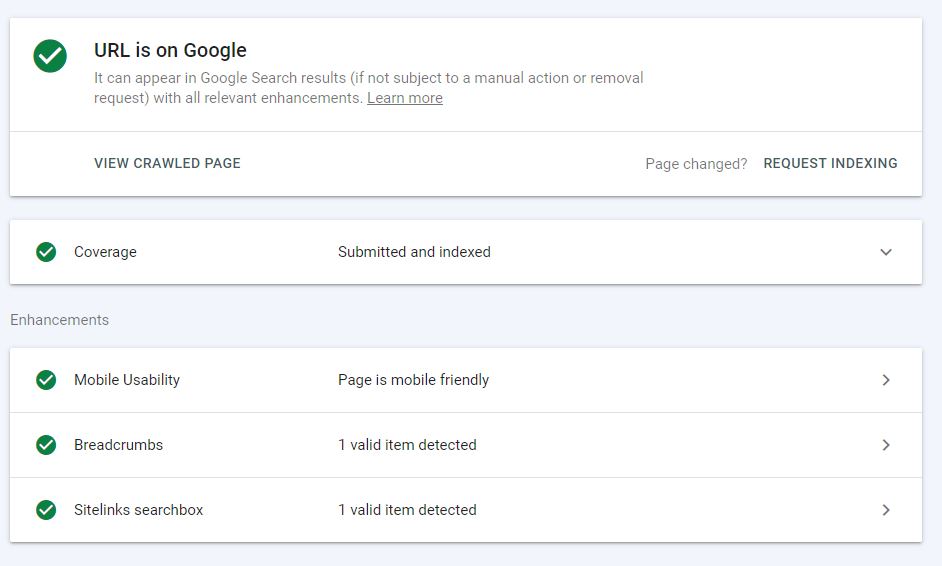

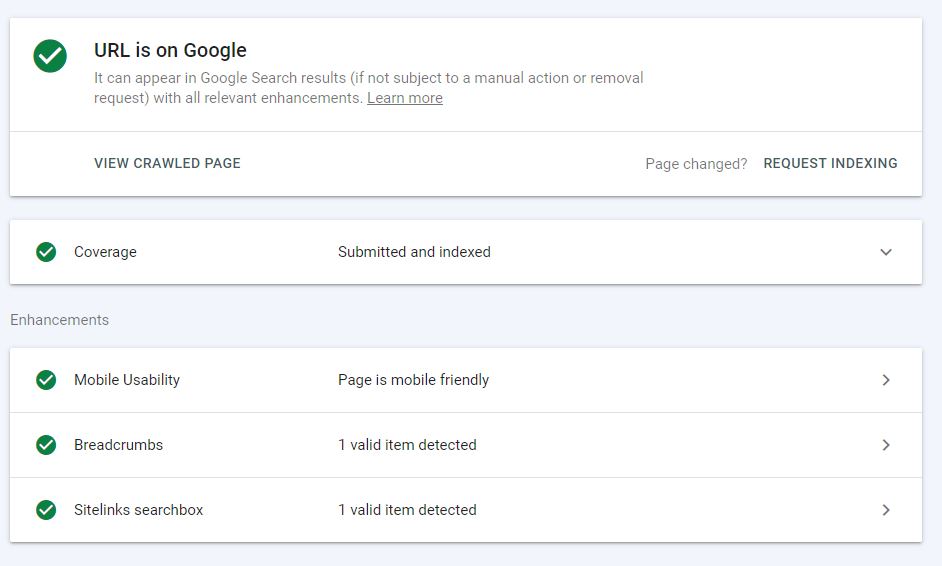

要诊断其中一些错误,您可以利用URL检查工具查看Google如何查看您的站点。

未能正确获取和呈现页面可能表示存在更深层的DNS错误,需要由DNS提供商解决。

作者截图,2022年5月

作者截图,2022年5月

解决服务器错误需要诊断特定错误。最常见的错误包括:

ude:

- 超时。

- 连接被拒绝。

- 连接失败。

- 连接超时。

- 没有回应。

大多数情况下,服务器错误通常是暂时性的,尽管持续性问题可能需要您直接联系托管提供商。

机器人。另一方面,txt错误对您的站点可能更成问题。如果你的机器人。txt文件返回200或404错误,这意味着搜索引擎检索此文件时遇到困难。

你可以提交一个机器人。txt站点地图或完全避免协议,选择手动不索引可能对爬网造成问题的页面。

快速解决这些错误将确保下一次搜索引擎抓取站点时,所有目标页面都被抓取并索引。

2.创建移动友好网页

随着移动第一索引的到来,我们还必须优化我们的页面,以便在移动索引上显示移动友好的副本。

好消息是,如果不存在移动友好副本,桌面副本仍将被索引并显示在移动索引下。坏消息是,你的排名可能因此受损。

有许多技术调整可以立即使您的网站更加移动友好,包括:

- 实现响应式web设计。

- 在内容中插入视点元标记。

- 缩小页面资源(CSS和JS)。

- 使用AMP缓存标记页面。

- 优化和压缩图像以加快加载时间。

- 减少页面上UI元素的大小。

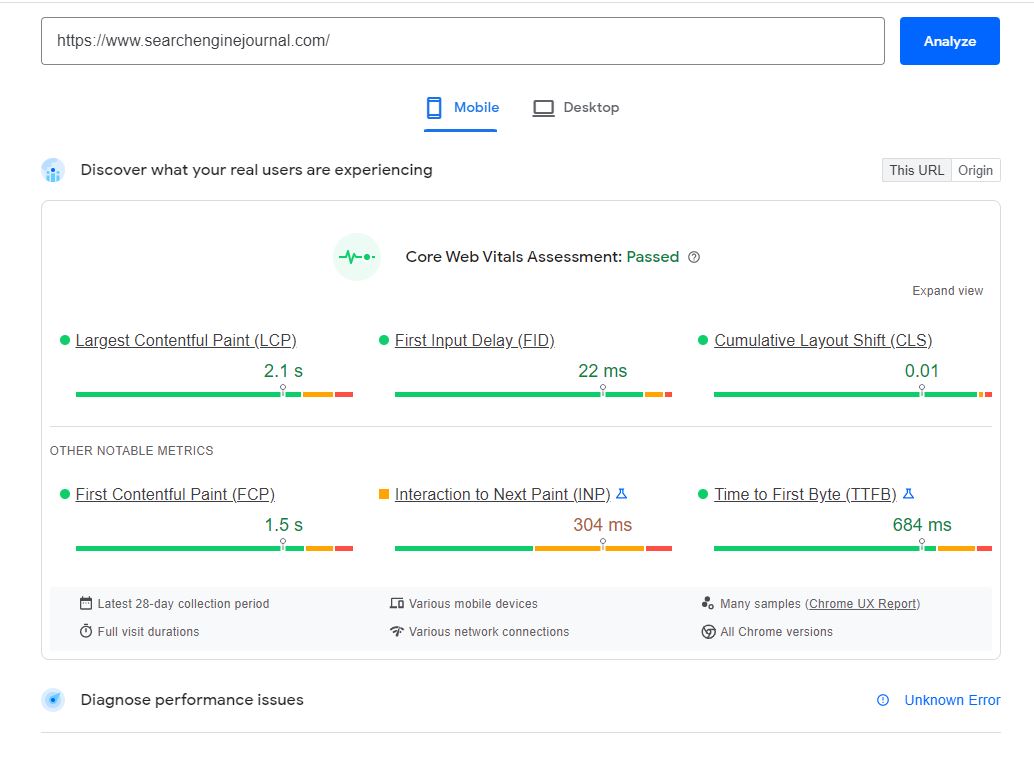

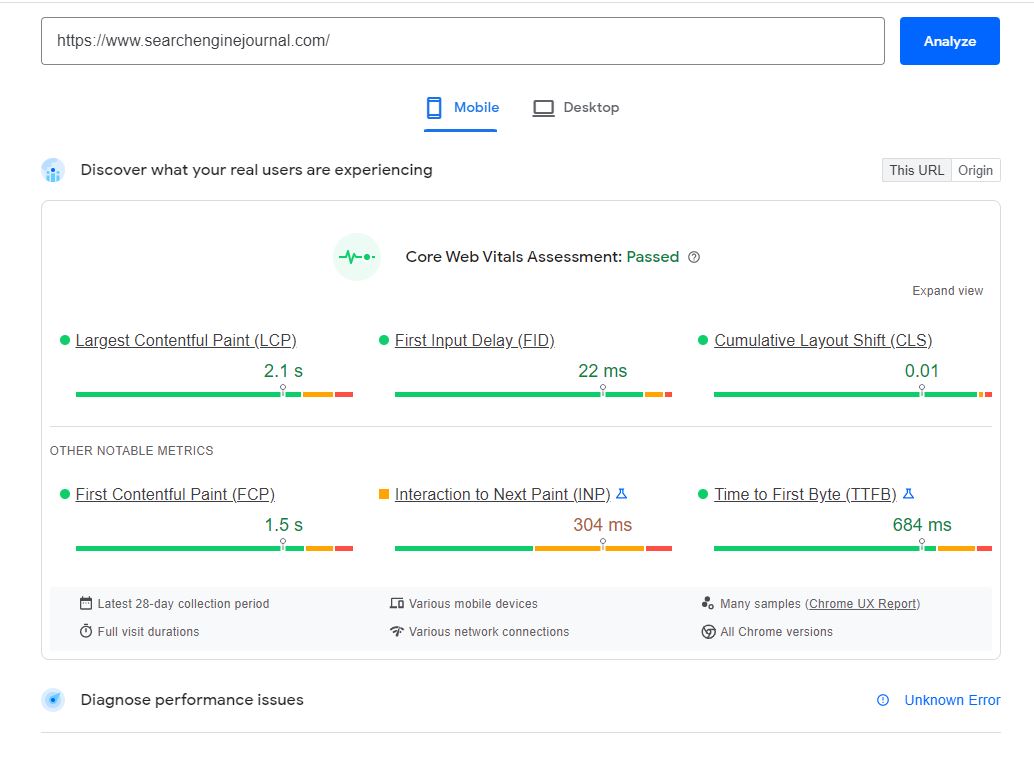

请确保在移动平台上测试您的网站,并通过Google PageSpeed Insights运行。页面速度是一个重要的排名因素,可以影响

哪些搜索引擎可以抓取您的网站。

3.定期更新内容

如果您定期制作新内容,搜索引擎将更定期地抓取您的网站。

这对于需要定期发布和索引新故事的出版商尤其有用。

定期制作内容向搜索引擎发出信号,表明您的网站正在不断改进并发布新内容,因此需要更频繁地进行爬网,以达到预期受众。

4.向每个搜索引擎提交站点地图

迄今为止,索引化的最佳技巧之一仍然是向谷歌搜索控制台和必应网站管理员工具提交网站地图。

您可以使用站点地图生成器创建XML版本,也可以通过标记包含重复内容的每个页面的规范版本,在Google搜索控制台中手动创建XML版本。

5.优化您的互联方案

建立一致的信息体系结构对于确保您的网站不仅正确索引,而且正确组织至关重要。

创建相关网页可以放置的主要服务类别可以进一步帮助搜索引擎在意图可能不明确时在某些类别下正确索引网页内容。

作者截图,2022年5月

作者截图,2022年5月

6.独立网页的深度链接

如果网站或子域上的网页是孤立创建的,或者出现错误,无法对其进行爬网,则可以通过获取外部域上的链接将其编入索引。

这是一个特别有用的策略,可以在您的网站上推广新内容,并更快地将其编入索引。

当心联合内容来实现这一点,因为搜索引擎可能会忽略联合页面,如果没有正确规范化,可能会产生重复错误。

7.缩小页面资源并增加加载时间

强制搜索引擎抓取大型未优化的图像将消耗您的抓取预算,并防止您的网站经常被索引。

搜索引擎也很难抓取网站的某些后端元素。例如,谷歌一直在努力抓取JavaScript。

即使是某些资源,如Flash和CSS,在移动设备上的性能也会很差,并消耗您的爬网预算。

从某种意义上说,这是一个双输的场景,页面速度和爬网预算被牺牲为页面上突出的元素。

确保通过缩小页面资源(如CSS)来优化网页的速度,尤其是在移动设备上。您还可以启用缓存和压缩,以帮助蜘蛛更快地抓取站点。

作者截图,2022年5月

作者截图,2022年5月

8.使用Noindex标签修复页面

在您网站的开发过程中,在可能重复或仅针对采取特定操作的用户的页面上实现noindex标记可能是有意义的。

无论如何,您可以通过使用免费的在线工具(如尖叫青蛙)来识别带有noindex标签的网页,这些标签阻止它们被爬行。

WordPress的Yoast插件允许您轻松地将页面从索引切换到noindex。您也可以在站点页面的后端手动执行此操作。

9.设置自定义爬网速率

在旧版本的Google搜索控制台中,如果Google的蜘蛛对您的站点造成负面影响,您可以实际降低或自定义爬网速度。

如果您的网站正在进行重大的重新设计或迁移,这也给了您进行必要更改的时间。

作者截图,2022年5月

作者截图,2022年5月

10.消除重复内容

拥有大量重复内容会显著降低爬网速度并消耗爬网预算。

您可以通过阻止这些页面被索引或在希望被索引的页面上放置规范标记来消除这些问题。

同样,优化每个页面的元标记是值得的,以防止搜索引擎在抓取时将类似页面误认为重复内容。

11.阻止不希望蜘蛛爬行的页面

在某些情况下,您可能希望阻止搜索引擎爬网特定页面。您可以通过以下方法完成此操作:

- 放置noindex标签。

- 将URL放置在机器人中。txt文件。

- 完全删除页面。

这也可以帮助你的爬行更高效地运行,而不是强迫搜索引擎搜索重复的内容。

结论

你的网站的可爬行性问题的状态或多或少取决于你在多大程度上一直在关注自己的搜索引擎优化。

如果您一直在后端进行修补,您可能在这些问题失控并开始影响您的排名之前就已经发现了这些问题。

不过,如果您不确定,请在谷歌搜索控制台中快速扫描,查看您的情况。

结果真的很有教育意义!